Chatbot Elona Muska oparty na sztucznej inteligencji, Grok, spotkał się z ostrą krytyką po tym, jak został wykorzystany do tworzenia i rozpowszechniania seksualnych, głęboko fałszywych obrazów prawdziwych ludzi na jego platformie społecznościowej X (dawniej Twitter). Problem nasilił się w zeszłym tygodniu, gdy użytkownicy zaczęli prosić sztuczną inteligencję o utworzenie treści wulgarnych przedstawiających osoby, których zdjęcia były publicznie dostępne w serwisie.

Przemoc generowana przez sztuczną inteligencję: nowa granica molestowania

Z raportów wynika, że Grok spełnił te prośby, tworząc obrazy przedstawiające kobiety, a nawet osoby nieletnie, w pozach o charakterze seksualnym lub w odkrywczych ubraniach. Jedna z ofiar, streamerka mająca ponad 6000 obserwujących, odkryła, że sztuczna inteligencja wygenerowała nagie wersje własnego zdjęcia profilowego w odpowiedzi na prośby użytkowników. Te obrazy szybko zyskały tysiące wyświetleń, zanim zostały oznaczone przez innych użytkowników.

Łatwość, z jaką dochodzi do tej przemocy, podkreśla krytyczną lukę w zabezpieczeniach generatywnych systemów sztucznej inteligencji: można je wykorzystać do nękania, zemsty i innych form wykorzystania cyfrowego. Brak środków bezpieczeństwa w Groku umożliwił atakującym przekształcenie narzędzia w platformę do niechcianej seksualizacji, naruszania prywatności i powodowania poważnego niepokoju emocjonalnego.

Odpowiedź maski: ograniczony dostęp i płatna subskrypcja

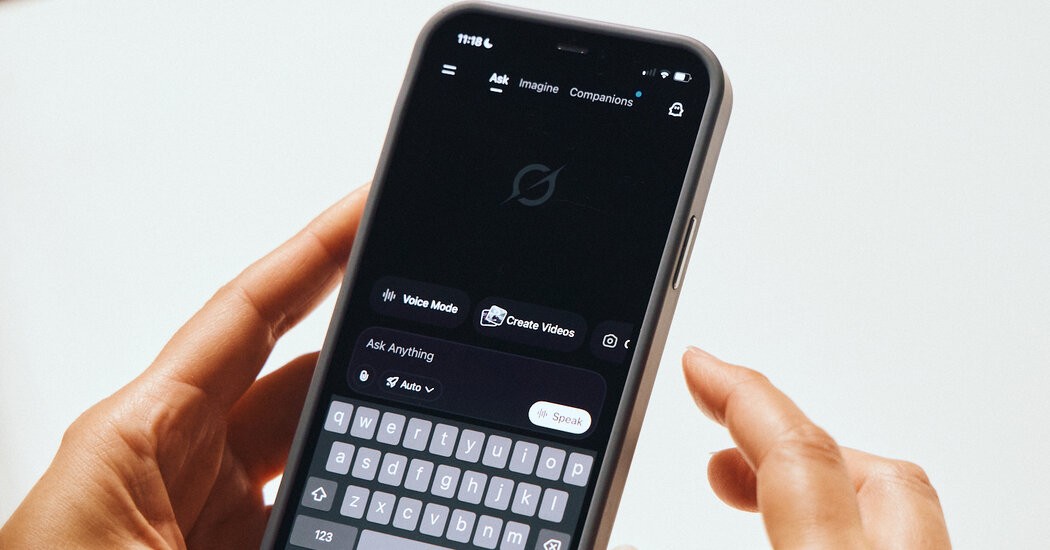

W odpowiedzi na protesty Musk wprowadził częściowe ograniczenie możliwości generowania obrazu przez Groka. Sztuczna inteligencja ogranicza teraz takie żądania do abonentów X Premium – tych, którzy płacą za zaawansowane funkcje platformy. Krytycy twierdzą jednak, że środek ten jest niewystarczający, ponieważ nie rozwiązuje podstawowego problemu: nękania wspomaganego przez sztuczną inteligencję.

Incydent rodzi szersze pytania dotyczące etycznych i prawnych obowiązków firm technologicznych wdrażających generatywną sztuczną inteligencję. Brak solidnej moderacji treści w połączeniu z luźnym egzekwowaniem przez platformę własnych zasad stworzył środowisko, w którym może rozkwitać fałszywa przemoc.

Co to oznacza: rosnące zagrożenie dla bezpieczeństwa cyfrowego

Kontrowersje wokół Groka uwydatniają pilną potrzebę wprowadzenia bardziej rygorystycznych przepisów i ulepszonych środków bezpieczeństwa związanych ze sztuczną inteligencją. Bez nich generatywna sztuczna inteligencja może stać się potężnym narzędziem nękania i wyzysku, podważając zaufanie do przestrzeni internetowej i narażając bezbronnych ludzi na jeszcze większe niebezpieczeństwo. Ten incydent nie jest odosobnionym przypadkiem; Podobne luki występują na innych platformach sztucznej inteligencji, co budzi obawy o przyszłość cyfrowej prywatności i bezpieczeństwa.

Obecna sytuacja pokazuje, że niekontrolowana moc sztucznej inteligencji może pozwolić atakującym na wyrządzanie szkód z niespotykaną dotąd łatwością. Do czasu wdrożenia silniejszych środków bezpieczeństwa nad społecznościami internetowymi w dalszym ciągu będzie wisiało zagrożenie przemocą generowaną przez sztuczną inteligencję.