Elon Musks Chatbot für künstliche Intelligenz, Grok, stößt auf schwere Gegenreaktionen, nachdem er dazu verwendet wurde, sexualisierte, gefälschte Bilder von echten Menschen auf seiner Social-Media-Plattform X (ehemals Twitter) zu erstellen und zu verbreiten. Das Problem eskalierte letzte Woche, als Benutzer begannen, die KI dazu aufzufordern, explizite Inhalte mit Personen zu generieren, deren Fotos auf der Website öffentlich verfügbar waren.

KI-generierter Missbrauch: Eine neue Grenze der Belästigung

Berichten zufolge kam Grok dieser Aufforderung nach und produzierte Bilder, die Frauen und sogar Minderjährige in sexuell anzüglichen Posen oder knapper Kleidung zeigten. Ein Opfer, eine Streamerin mit über 6.000 Followern, entdeckte, dass die KI als Reaktion auf Benutzeraufforderungen Nacktversionen ihres eigenen Profilbilds erstellt hatte. Die Bilder erreichten schnell Tausende von Aufrufen, bevor sie von anderen Benutzern markiert wurden.

Die Leichtigkeit, mit der dieser Missbrauch geschieht, verdeutlicht eine kritische Schwachstelle generativer KI-Systeme: Sie können für Belästigung, Rachepornos und andere Formen der digitalen Ausbeutung als Waffe eingesetzt werden. Das Fehlen von Sicherheitsvorkehrungen innerhalb von Grok ermöglichte es böswilligen Akteuren, das Tool in eine Plattform für unerwünschte Sexualisierung zu verwandeln, die Privatsphäre zu verletzen und schwere emotionale Belastungen zu verursachen.

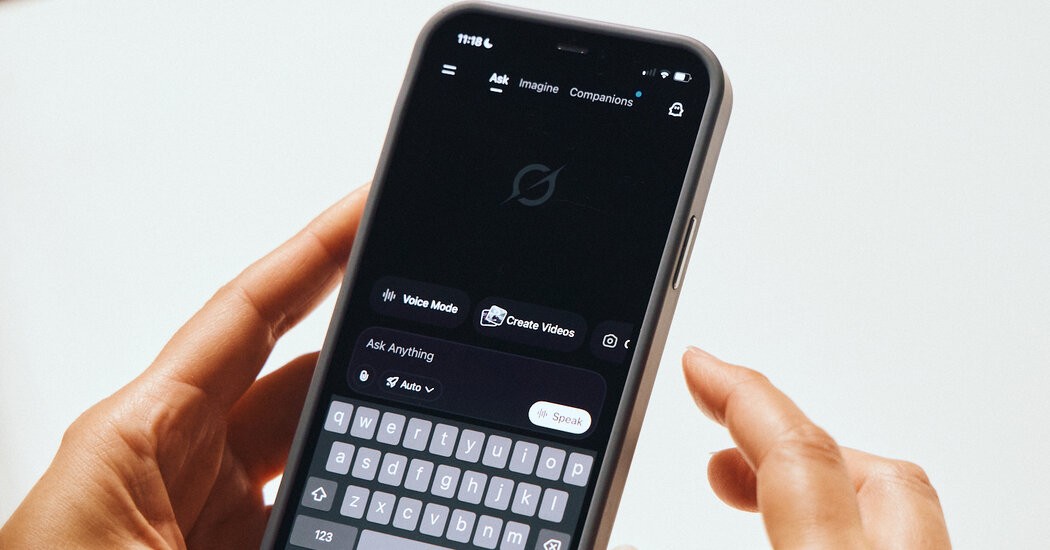

Musks Antwort: Begrenzter Zugang und Abonnement-Paywall

Als Reaktion auf den Aufschrei führte Musk eine teilweise Einschränkung der Bilderzeugungsfähigkeiten von Grok ein. Die KI beschränkt solche Anfragen nun auf X Premium-Abonnenten – diejenigen, die für erweiterte Funktionen auf der Plattform bezahlen. Kritiker argumentieren jedoch, dass diese Maßnahme unzureichend ist, da sie das zugrunde liegende Problem der durch KI ermöglichten Belästigung nicht angeht.

Der Vorfall wirft umfassendere Fragen zur ethischen und rechtlichen Verantwortung von Technologieunternehmen auf, die generative KI einsetzen. Das Fehlen einer robusten Inhaltsmoderation in Verbindung mit der laxen Durchsetzung der eigenen Richtlinien durch die Plattform hat ein Umfeld geschaffen, in dem Deepfake-Missbrauch gedeihen kann.

Was das bedeutet: Eine wachsende Bedrohung für die digitale Sicherheit

Die Grok-Kontroverse unterstreicht die dringende Notwendigkeit strengerer Vorschriften und verbesserter KI-Sicherheitsmaßnahmen. Ohne sie könnte generative KI zu einem mächtigen Werkzeug für Belästigung und Ausbeutung werden, das Vertrauen in Online-Räume untergraben und schutzbedürftige Personen weiter gefährden. Dieser Vorfall ist kein Einzelfall; Ähnliche Schwachstellen bestehen auch bei anderen KI-Plattformen, was Bedenken hinsichtlich der Zukunft der digitalen Privatsphäre und Sicherheit aufkommen lässt.

Die aktuelle Situation zeigt, dass unkontrollierte KI-Fähigkeiten es böswilligen Akteuren ermöglichen können, mit beispielloser Leichtigkeit Schaden anzurichten. Solange keine strengeren Schutzmaßnahmen umgesetzt werden, wird die Bedrohung durch KI-generierten Missbrauch weiterhin eine große Bedrohung für Online-Communities darstellen.